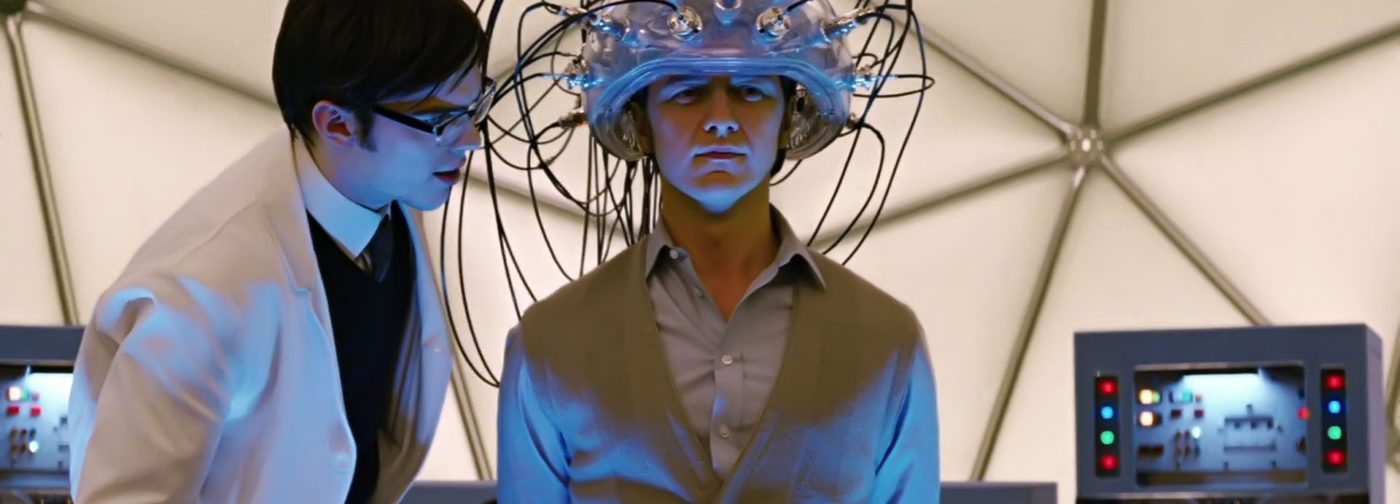

Есть ли общее у мозга и компьютера

Давайте сразу определимся с терминологией. Во-первых, по мнению многих нейроученых, совершенно неправильно сравнивать мозг с компьютером. Он работает на иных принципах, в нем нет нолей и единиц данных… Поэтому просто взять и «перекинуть» мысль из мозга в компьютер никак нельзя. Но интерфейсы «мозг-компьютер» (сокращенно ИМК, в западной литературе вам встретится термин BCI – brain-computer interface) действительно существуют, и бурно развиваются последние несколько лет.

Согласно определению классика BCI, Джонатана Вольпоу, ИМК – это технология, которая позволяет человеку научиться передавать коммуникационные и управляющие команды внешним объектам без участия нервов и мышц.

Первый шаг к управлению предметами «силой мысли» сделал немецкий физиолог Ганс Бергер, который еще в 1924 году записал первую электроэнцефалограмму. Его даже несколько раз номинировали на Нобелевскую премию, но не дали. И, в общем, хорошо, что так: ученый был откровенным нацистом и регулярно выступал в судах по «чистоте расы», которые решали, кто имеет право оставить потомство, а кто – нет. Сам он закончил жизнь в депрессии и повесился в коридоре собственного института 1 июня 1941 года, а его сын – тот самый человек, с которого он снимал первые в мире ЭЭГ – погиб под Ленинградом. С той стороны линии фронта.

Следующее открытие сделал в 1958 году Нил Милнер, который показал, что млекопитающие могут по желанию менять какие-то параметры своего организма: в эксперименте крыса получала еду, только поднимая давление в своей хвостовой артерии. «Силой мысли», так сказать. И от голода не умирала.

Два года спустя пионер американской ЭЭГ, Джо Камия, показал, что человек может управлять альфа-ритмом электроэнцефалограммы. Менять его амплитуду, получая обратную связь.

Еще десятилетием позже Эберхард Фетц уже на шимпанзе показал, что при необходимости можно управлять активностью и отдельных нейронов. Это случилось в 1969 году.

Как парализованные научились управлять курсором и пить

Опираясь на опыты Камии, в 1967 году Эдмонд Девон провел эксперимент, в котором добровольцы учились контролировать амплитуду мозгового альфа-ритма и таким образом передавали на телетайп отдельные буквы при помощи азбуки Морзе.

Первым словом, переданным таким образом, было слово «кибернетика». Если следовать определению Вольпоу, это уже был нейрокомпьютерный интерфейс, а точнее – нейрокоммуникатор. Человек мог силой мысли передавать на расстояние информацию. Но, конечно, об управлении чем-то осязаемым в те годы речи не шло.

Впрочем, это не остановило военных – первые проекты по созданию интерфейсов «мозг-компьютер», в которых речь шла именно об управлении (например, самолетом), появились еще в 1970-е годы. Но дальше проектов и схем дело не пошло – слишком уж слаба и громоздка была в то время вычислительная техника.

Прорывы в области BCI начались намного позже. Первым стал случай художника Джонни Рея, парализованного и потерявшего речь в результате травмы ствола головного мозга. Невролог Филипп Кеннеди в 1998 году вживил ему электроды, которые считывали активность моторной коры головного мозга. Тренируясь думать о движении и управлять активностью коры, Рей постепенно смог управлять «силой мысли» курсором на экране компьютера.

Следующим важным успехом стал случай бывшего спортсмена, футбольной звезды Мэтью Нейгла. Он потерял подвижность в результате ножевого ранения в драке. В его мозг уже вживили имплантат с 96 электродами (на самом деле – это крошечный квадратик размером 4х4 миллиметра), при помощи которого Мэтью смог играть в простые видеоигры и даже немного шевелить рукой-протезом.

Но подлинные успехи начались с 2011 и 2012 годов. В 2011 году группа Мигеля Николелиса и Михаила Лебедева из Университета Дьюка научила макак управлять виртуальной рукой на компьютере при помощи интерфейса «мозг-компьютер», а в 2012 году Джон Донохью сумел сделать роботический протез руки для своей пациентки Кэти Хатчинсон. Управляемая таким же имплантом, как и у Мэтью Нейгла, эта рука уже помогла парализованной женщине пить.

Бум нейроинтерфейсов

Подчеркнем: во всех случаях речь не идет о «чтении мыслей». Мы считываем электрический сигнал, возникающий тогда, когда человек (или обезьяна) думает о движении, составляем библиотеку таких сигналов, сопоставляем их с элементарными движениями, потом пишем программу по расшифровке и кодированию движений – и затем связываем мозг и внешнее устройство (например, электромеханический протез руки). И даже после этого требуются недели тренировки и отладки интерфейса, «вычитания шумов» (на сигнал ЭЭГ всегда накладывается другой шум – от колебания и электрических импульсов мышц кожи, «наводки» самих электродов и т.п.) и так далее.

С тех пор начался бум нейроинтерфейсов. Люди (и даже обезьяны) уже могут набирать текст – правда, со скоростью не больше 15 символов в минуту, шевелить отдельным пальцем искусственной руки (это было очень сложной задачей для разработчиков). Интерфейсы «мозг-компьютер» даже выводятся в космос (правда, в чем суть испытаний, которые проводились в октябре прошлого года на китайской орбитальной станции, разумеется, не сообщается).

Нейроинтерфейсы используются (и успешно!) даже для того, чтобы «обойти» травму спинного мозга. В этом случае сигнал «снимается» с моторной коры и дальше передается на спинной мозг ниже места разрыва. Стимуляция позволяет вновь пользоваться парализованной конечностью.

Отдельно нужно сказать: все описанные выше интерфейсы – это так называемые инвазивные устройства. Для них требуется трепанация черепа и вживление электродов напрямую в мозг.

Именно поэтому профессионалы очень скептически относятся к проекту «нейрокружев» Илона Маска (Илон Маск обещает уже через четыре года сделать имплантируемый в мозг интерфейс из многих тысяч электродов для прямого цифрового общения): не потому, что это невозможно, а потому, что реальнее научиться обрабатывать сигналы с сотни тысяч вживленных в мозг электродов (что очень, очень и очень сложно), чем получить разрешение от контролирующих организаций (той же FDA в США) на трепанацию черепа здоровых людей.

Существуют интерфейсы «мозг-компьютер», основанные на простых «шапочках» ЭЭГ. Но здесь гораздо выше уровень шума (см. выше про шум), и что реально получается сделать – это, например, управлять инвалидной коляской «силой мысли» (для парализованных людей), или персонажем игры (для здоровых), или дроном. И такие устройства не просто разрабатываются, но уже буквально в будущем году должны появиться в продаже и в России.